前編のLoRA導入編はこちら

今回はLoRA調整編ということでまずどんな感じに出力できたか画像を見せてみる

こんな感じになった

前回の最後にある画像とそんなに変わらないレベルの出来栄え

このLoRAを暫く使い、手直しした立ち絵をyoutubeのサムネ等に使っていき、ある程度データが集まったら修正後のLoRAをまた作る予定

紹介はこれで終わり、ここから”LoRA Easy Training Scripts”の調整箇所の説明を行っていく(導入方法は前回の記事を見てね)

左側のタブを上から順に僕が触った項目を説明していく

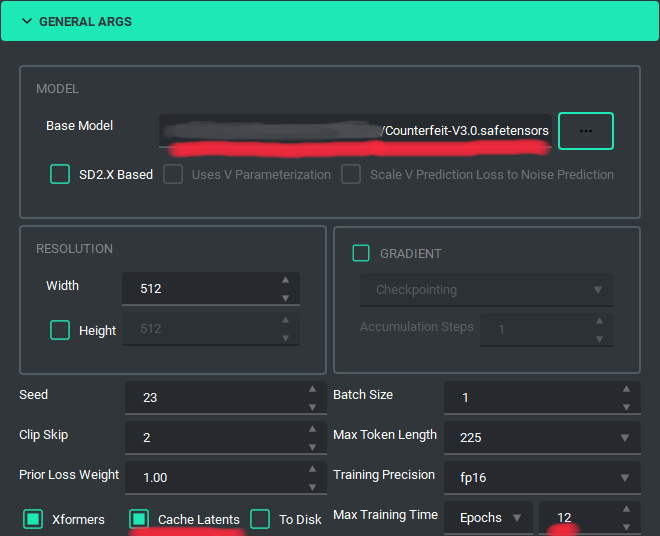

「GENERAL ARGS」

・Base Model

教育時に参照するcheckpointを選択(僕はCounterfeitを使用)

・Cache Latents

VRAMの使用量を削減できるらしいからチェックした

・Max Training Time

Epochs 12に設定した(詳細は繰り返し回数と共に後述)

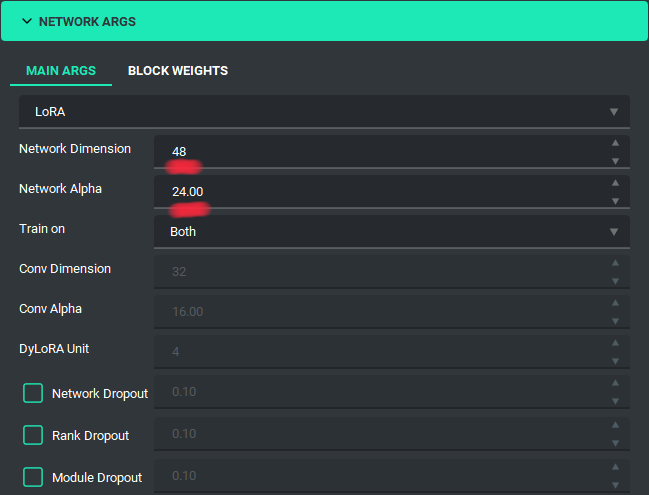

「NETWORK ARGS」

・Network Dimension

よく分からないけど8~128あたりで調整したら結果が変わる

・Network Alpha

Network Dimensionの半分の値にする

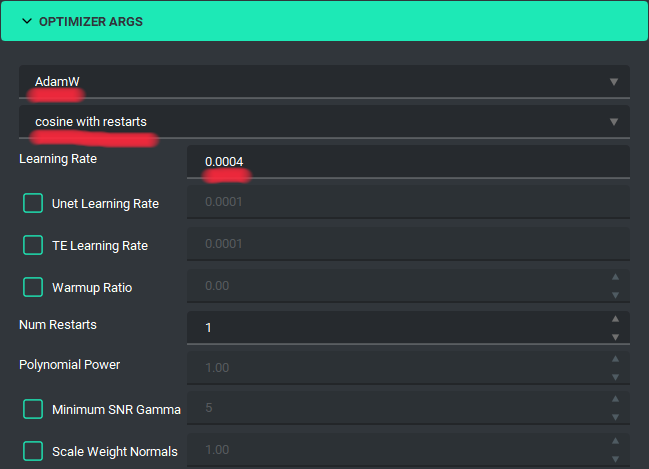

「OPTMIZER ARGS」

・オプティマイザ選択(AdamWの欄)

AdamWがよく使われているらしい

AdamW8bitがメモリ使用量が少ないという記事も見た気がする

・スケジューラー選択(cosine with restartsの欄)

cosine with restartsは学習に時間がかかるが過学習し辛いらしい

・Learning Rate

学習率の設定らしい

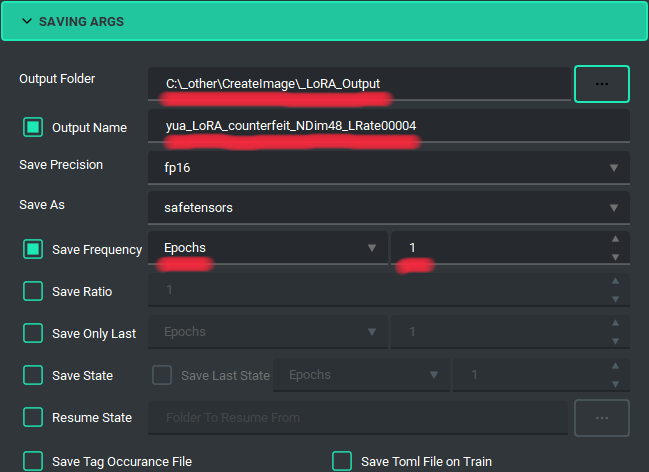

「SAVING ARGS」

・Output Folder

学習結果LoRAの保存先の選択

・Output Name

保存するLoRAのファイル名

・(Save Frequency)

指定タイミング毎に学習データを残してくれる

画像の状態だと1Epochs毎にLoRAが保存される

学習させている最中にどこから過学習になるか分からない為、全部残すと確認が楽

「BUCKET ARGS」

・ENABLEのチェックを外す

学習させる画像サイズについての設定らしいけど画像サイズが全て同じなら不要みたい

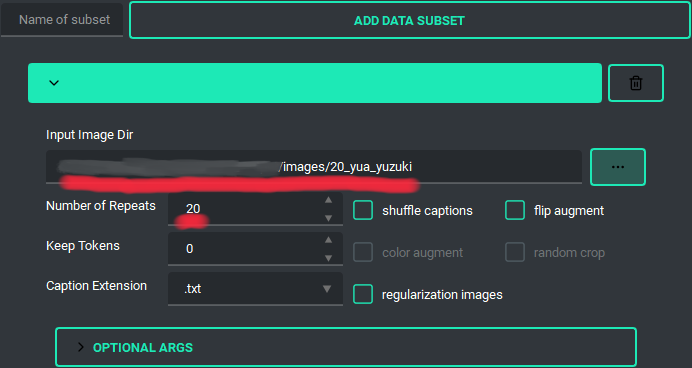

「右側のリスト」

・input image Dir

学習元のフォルダを選択

(・Number of Repeats)

学習元フォルダを選択したら(フォルダ名の先頭の値が)勝手に数値が入る

繰り返し回数と呼ばれる項目

ここで繰り返し回数・Epochsについて説明すると、どれくらい学習を行うかの数値になるらしく、計算は単純で

「画像数 * epochs * 繰り返し回数 = ステップ数」となる

調べてる中では画像数を20枚程度にしてステップ数を2000~10000前後になるよう調整するのがいいみたい?

上に画像を貼ったけど学習不足だと似てない、過学習だと絵が破綻したりする

あとは赤文字にした項目の数値を上下させて自分的に綺麗なLoRAができたら完成!!

上で書いたけどいったん今回できたLoRAを使っていき、手直しした画像を使って再度LoRAを作る予定

まあ将来的にやるかも、って感じだから今回の作り方を再度行うかもしれないし、また新しいAI画像生成の技術ができたらそっちつかうかもしれないって感じかな